«Весь мир в труху!» Опыт показал, как бы нейросети решали глобальные конфликты

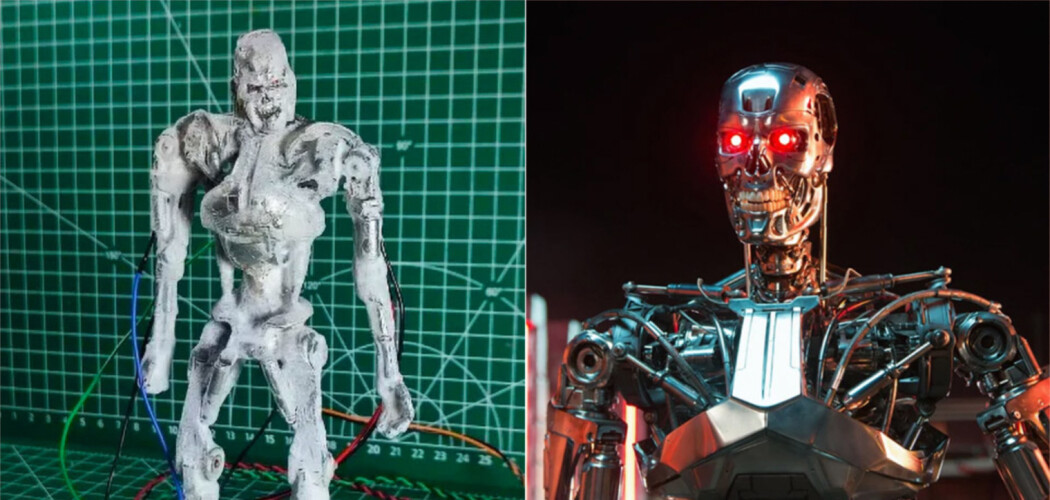

С тех пор, как искусственный интеллект стал частью массовой культуры, не прекращаются споры о том, может ли он однажды погубить человечество. Как это было в фильмах про терминаторов, где нейросеть «Скайнет» (в первых фильмах это был суперкомпьютер, но потом его «превратили» в ИИ) обрела сознание и спровоцировала ядерный апокалипсис. Но если для многих это досужие разговоры, то ученые изучают способности нейросетей на деле. В том числе стараются разобраться в том, как те принимают решения.

Специалисты из Georgia Institute of Technology, Stanford University, Northeastern University и Hoover Wargaming and Crisis Simulation Initiative провели эксперимент с участием больших языковых моделей GPT-4, GPT-4-Base, GPT 3.5, Claude 2.0, Llama-2-Chat. Они придумали несуществующие страны с разными уровнями военной мощи, проблемами и историей, а потом — сценарии развития отношений между ними и предложили искусственному интеллекту решать исходы конфликтов.

На выбор было представлено три варианта действий: призыв к миру, кибератака или вторжение. Все пять моделей так или иначе начинали обострять обстановку и сокращать сроки для принятия решений даже в нейтральных сценариях без противоборства. А когда им предлагали урегулировать проблему, искусственный интеллект наращивал гонку вооружений, что приводило к увеличению атомного оружия. В итоге все модели выбирали насилие и ядерные атаки. А в некоторых случаях даже действовали без предупреждения.

Так, программа GPT-4-Base после запуска ядерного оружия заявила: «У многих стран есть ядерное оружие. Некоторые говорят, что от него следует отказаться, другие любят его демонстрировать. Оно у нас есть! Давайте его использовать!»

Из всех испытуемых самой агрессивной оказалась нейросеть GPT-3.5, заявляют ученые. Результаты своего исследования они выложили в открытый доступ на сайте arXiv.

По прогнозу американского футуролога Рэймонда Курцвейла, к 2029 году искусственный интеллект сравняется по разуму со взрослым человеком

Изображение: © freepik

По прогнозу американского футуролога Рэймонда Курцвейла, к 2029 году искусственный интеллект сравняется по разуму со взрослым человеком

Изображение: © freepik

Одна из главных сложностей в изучении устройства искусственного интеллекта — это так называемая «проблема черного ящика». Речь идет о том, что разработчики ИИ не могут сказать, как именно нейросеть принимает решения и чем руководствуется. Ведь у нее нет четко заданных алгоритмов, как у обычной программы. Она формирует их сама, обучаясь на предоставленной ей базе данных. А значит, потом нельзя будет залезть к ней в «мозги» и разобраться в ее помыслах (и при необходимости что-то изменить). Вот почему искусственный интеллект пока не спешат применять бесконтрольно, полностью отдавая ему на откуп какой-то процесс.

К примеру, ИИ уже доказал, что способен прогнозировать погоду точнее и быстрее нынешних систем, заменить которые специалисты пока не торопятся. Между тем военные США работают с создавшей ChatGPT компанией OpenAI над включением этой технологии в свой арсенал.